選自 Sebastian Raschka 博客

【資料圖】

【資料圖】

機(jī)器之心編譯

機(jī)器之心編輯部

關(guān)于 PyTorch 煉丹,本文作者表示:「如果你有 8 個(gè) GPU,整個(gè)訓(xùn)練過程只需要 2 分鐘,實(shí)現(xiàn) 11.5 倍的性能加速。」

如何提升 PyTorch「煉丹」速度?

最近,知名機(jī)器學(xué)習(xí)與 AI 研究者 Sebastian Raschka 向我們展示了他的絕招。據(jù)他表示,他的方法在不影響模型準(zhǔn)確率的情況下,僅僅通過改變幾行代碼,將 BERT 優(yōu)化時(shí)間從 22.63 分鐘縮減到 3.15 分鐘,訓(xùn)練速度足足提升了 7 倍。

作者更是表示,如果你有 8 個(gè) GPU 可用,整個(gè)訓(xùn)練過程只需要 2 分鐘,實(shí)現(xiàn) 11.5 倍的性能加速。

下面我們來看看他到底是如何實(shí)現(xiàn)的。

讓 PyTorch 模型訓(xùn)練更快

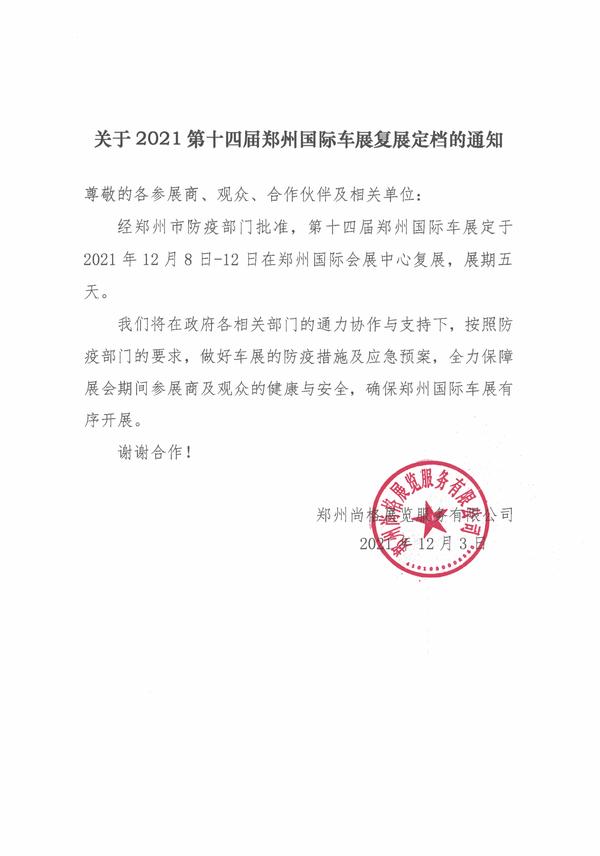

首先是模型,作者采用 DistilBERT 模型進(jìn)行研究,它是 BERT 的精簡(jiǎn)版,與 BERT 相比規(guī)模縮小了 40%,但性能幾乎沒有損失。其次是數(shù)據(jù)集,訓(xùn)練數(shù)據(jù)集為大型電影評(píng)論數(shù)據(jù)集 IMDB Large Movie Review,該數(shù)據(jù)集總共包含 50000 條電影評(píng)論。作者將使用下圖中的 c 方法來預(yù)測(cè)數(shù)據(jù)集中的影評(píng)情緒。

基本任務(wù)交代清楚后,下面就是 PyTorch 的訓(xùn)練過程。為了讓大家更好地理解這項(xiàng)任務(wù),作者還貼心地介紹了一下熱身練習(xí),即如何在 IMDB 電影評(píng)論數(shù)據(jù)集上訓(xùn)練 DistilBERT 模型。如果你想自己運(yùn)行代碼,可以使用相關(guān)的 Python 庫設(shè)置一個(gè)虛擬環(huán)境,如下所示:

相關(guān)軟件的版本如下:

現(xiàn)在省略掉枯燥的數(shù)據(jù)加載介紹,只需要了解本文將數(shù)據(jù)集劃分為 35000 個(gè)訓(xùn)練示例、5000 個(gè)驗(yàn)證示例和 10000 個(gè)測(cè)試示例。需要的代碼如下:

代碼部分截圖

完整代碼地址:

https://github.com/rasbt/faster-pytorch-blog/blob/main/1_pytorch-distilbert.py

然后在 A100 GPU 上運(yùn)行代碼,得到如下結(jié)果:

部分結(jié)果截圖

正如上述代碼所示,模型從第 2 輪到第 3 輪開始有一點(diǎn)過擬合,驗(yàn)證準(zhǔn)確率從 92.89% 下降到了 92.09%。在模型運(yùn)行了 22.63 分鐘后進(jìn)行微調(diào),最終的測(cè)試準(zhǔn)確率為 91.43%。

使用 Trainer 類

接下來是改進(jìn)上述代碼,改進(jìn)部分主要是把 PyTorch 模型包裝在 LightningModule 中,這樣就可以使用來自 Lightning 的 Trainer 類。部分代碼截圖如下:

完整代碼地址:https://github.com/rasbt/faster-pytorch-blog/blob/main/2_pytorch-with-trainer.py

上述代碼建立了一個(gè) LightningModule,它定義了如何執(zhí)行訓(xùn)練、驗(yàn)證和測(cè)試。相比于前面給出的代碼,主要變化是在第 5 部分(即 ### 5 Finetuning),即微調(diào)模型。與以前不同的是,微調(diào)部分在 LightningModel 類中包裝了 PyTorch 模型,并使用 Trainer 類來擬合模型。

之前的代碼顯示驗(yàn)證準(zhǔn)確率從第 2 輪到第 3 輪有所下降,但改進(jìn)后的代碼使用了 ModelCheckpoint 以加載最佳模型。在同一臺(tái)機(jī)器上,這個(gè)模型在 23.09 分鐘內(nèi)達(dá)到了 92% 的測(cè)試準(zhǔn)確率。

需要注意,如果禁用 checkpointing 并允許 PyTorch 以非確定性模式運(yùn)行,本次運(yùn)行最終將獲得與普通 PyTorch 相同的運(yùn)行時(shí)間(時(shí)間為 22.63 分而不是 23.09 分)。

自動(dòng)混合精度訓(xùn)練

進(jìn)一步,如果 GPU 支持混合精度訓(xùn)練,可以開啟 GPU 以提高計(jì)算效率。作者使用自動(dòng)混合精度訓(xùn)練,在 32 位和 16 位浮點(diǎn)之間切換而不會(huì)犧牲準(zhǔn)確率。

在這一優(yōu)化下,使用 Trainer 類,即能通過一行代碼實(shí)現(xiàn)自動(dòng)混合精度訓(xùn)練:

上述操作可以將訓(xùn)練時(shí)間從 23.09 分鐘縮短到 8.75 分鐘,這幾乎快了 3 倍。測(cè)試集的準(zhǔn)確率為 92.2%,甚至比之前的 92.0% 還略有提高。

使用 Torch.Compile 靜態(tài)圖

最近 PyTorch 2.0 公告顯示,PyTorch 團(tuán)隊(duì)引入了新的 toch.compile 函數(shù)。該函數(shù)可以通過生成優(yōu)化的靜態(tài)圖來加速 PyTorch 代碼執(zhí)行,而不是使用動(dòng)態(tài)圖運(yùn)行 PyTorch 代碼。

由于 PyTorch 2.0 尚未正式發(fā)布,因而必須先要安裝 torchtriton,并更新到 PyTorch 最新版本才能使用此功能。

然后通過添加這一行對(duì)代碼進(jìn)行修改:

在 4 塊 GPU 上進(jìn)行分布式數(shù)據(jù)并行

上文介紹了在單 GPU 上加速代碼的混合精度訓(xùn)練,接下來介紹多 GPU 訓(xùn)練策略。下圖總結(jié)了幾種不同的多 GPU 訓(xùn)練技術(shù)。

想要實(shí)現(xiàn)分布式數(shù)據(jù)并行,可以通過 DistributedDataParallel 來實(shí)現(xiàn),只需修改一行代碼就能使用 Trainer。

經(jīng)過這一步優(yōu)化,在 4 個(gè) A100 GPU 上,這段代碼運(yùn)行了 3.52 分鐘就達(dá)到了 93.1% 的測(cè)試準(zhǔn)確率。

DeepSpeed

最后,作者探索了在 Trainer 中使用深度學(xué)習(xí)優(yōu)化庫 DeepSpeed 以及多 GPU 策略的結(jié)果。首先必須安裝 DeepSpeed 庫:

接著只需更改一行代碼即可啟用該庫:

這一波下來,用時(shí) 3.15 分鐘就達(dá)到了 92.6% 的測(cè)試準(zhǔn)確率。不過 PyTorch 也有 DeepSpeed 的替代方案:fully-sharded DataParallel,通過 strategy="fsdp" 調(diào)用,最后花費(fèi) 3.62 分鐘完成。

以上就是作者提高 PyTorch 模型訓(xùn)練速度的方法,感興趣的小伙伴可以跟著原博客嘗試一下,相信你會(huì)得到想要的結(jié)果。

原文鏈接:https://sebastianraschka.com/blog/2023/pytorch-faster.html

探尋隱私計(jì)算最新行業(yè)技術(shù),「首屆隱語開源社區(qū)開放日」報(bào)名啟程

春暖花開之際,誠邀廣大技術(shù)開發(fā)者 & 產(chǎn)業(yè)用戶相聚活動(dòng)現(xiàn)場(chǎng),體驗(yàn)數(shù)智時(shí)代的隱私計(jì)算生態(tài)建設(shè)之旅,一站構(gòu)建隱私計(jì)算產(chǎn)業(yè)體系知識(shí):

隱私計(jì)算領(lǐng)域焦點(diǎn)之性

分布式計(jì)算系統(tǒng)的短板與升級(jí)策略

隱私計(jì)算跨平臺(tái)互聯(lián)互通

隱語開源框架金融行業(yè)實(shí)戰(zhàn)經(jīng)驗(yàn)

3 月 29 日,北京 · 798 機(jī)遇空間,隱語開源社區(qū)開放日,期待線下面基。

-

快資訊:營(yíng)收360億元!平煤股份2022年盈利57.25億元,近乎翻倍

頭條 23-03-12

-

硅谷銀行破產(chǎn)沖擊開始蔓延,英國(guó)180家企業(yè)求政府干預(yù)

頭條 23-03-12

-

美媒:對(duì)沖基金提出折價(jià)收購硅谷銀行的創(chuàng)業(yè)公司存款

頭條 23-03-12

-

下周,國(guó)內(nèi)一眾超市大佬要在許昌商量大事 環(huán)球今亮點(diǎn)

頭條 23-03-12

-

美監(jiān)管機(jī)構(gòu)最快下周一返還硅谷銀行客戶部分未受保存款

頭條 23-03-12

-

全球微頭條丨英國(guó)倫敦銀行考慮收購美國(guó)硅谷銀行英國(guó)分行

頭條 23-03-12

-

萬億硅谷銀行破產(chǎn),會(huì)否引發(fā)金融海嘯?最新解讀來了|百事通

頭條 23-03-12

-

美媒:投資者呼吁美國(guó)政府介入硅谷銀行倒閉事件 每日速遞

頭條 23-03-12

-

美國(guó)聯(lián)邦存款保險(xiǎn)公司為硅谷銀行員工提供45天聘期及1.5倍工資

頭條 23-03-12

-

直播 | 十四屆全國(guó)人大一次會(huì)議第三場(chǎng)“代表通道”_最新消息

頭條 23-03-12

-

時(shí)間線|從爆雷到破產(chǎn),硅谷銀行的48小時(shí)|全球熱議

頭條 23-03-11

-

【世界新視野】信陽市委書記蔡松濤:大力發(fā)展綠色金融,著力打造綠色發(fā)展新引擎

頭條 23-03-11

-

世界熱訊:美國(guó)硅谷銀行宣布破產(chǎn),浦發(fā)硅谷銀行緊急發(fā)聲

頭條 23-03-11

-

美國(guó)硅谷銀行倒閉,“銀行界的寵兒”何以失寵?

頭條 23-03-11

-

宇通重卡牽手中建科工!將圍繞這一領(lǐng)域展開合作

頭條 23-03-11

-

計(jì)劃完成投資128.2億元!洛陽交通今年這么干 環(huán)球快看點(diǎn)

頭條 23-03-11

-

全球即時(shí):十四屆全國(guó)人大一次會(huì)議第四次全體會(huì)議 | 直播

頭條 23-03-11

-

年度投資突破5000億元,2023年鄭州重大項(xiàng)目建設(shè)任務(wù)有這些

頭條 23-03-11

-

又見證歷史!昨夜,“轟然倒塌”,宣布倒閉!|全球觀焦點(diǎn)

頭條 23-03-11

-

美國(guó)宣布取消針對(duì)中國(guó)赴美旅客的新冠檢測(cè)要求 世界播資訊

頭條 23-03-11

-

世界微資訊!大手筆!力量鉆石擬使用不超40億元閑置資金進(jìn)行現(xiàn)金管理

頭條 23-03-10

-

力量鉆石:擬出資3億元在鄭州設(shè)立全資子公司

頭條 23-03-10

-

洛陽市委召開專題會(huì)議 研究利用資本市場(chǎng)工作

頭條 23-03-10

-

觀速訊丨七大行動(dòng)激發(fā)活力,今年河南將這樣大力促消費(fèi)

頭條 23-03-10

- 環(huán)球熱門:改變幾行代碼,PyTorch 煉丹速度2023-03-12

- 全球熱頭條丨二三孩中考加 10 分?教育公2023-03-12

- 當(dāng)前速遞!盈利增長(zhǎng)200%!平高電氣2022年2023-03-12

- 快資訊:營(yíng)收360億元!平煤股份2022年盈利52023-03-12

- 頭條:大到暴雪!黑龍江省發(fā)布大雪預(yù)報(bào)、道2023-03-12

- 河南滎陽發(fā)布高森林火險(xiǎn)紅色預(yù)警2023-03-12

- 環(huán)球速遞!李家超:國(guó)歌代表國(guó)家尊嚴(yán),將竭2023-03-12

- 強(qiáng)化農(nóng)業(yè)科技全鏈競(jìng)爭(zhēng)力2023-03-12

- 新華全媒+|貨物“跨山越海” 暢通經(jīng)濟(jì)循環(huán)2023-03-12

- 海南五指山:發(fā)現(xiàn)“水中大熊貓”之稱的桃花2023-03-12

- 今天是植樹節(jié):為地球增添更多中國(guó)綠2023-03-12

- 【快播報(bào)】浙江選育出了“螺螄粉”櫻花,到2023-03-12

- 詩意滿滿!今天植樹節(jié),感受植物中的中國(guó)式2023-03-12

- 筑牢個(gè)人信息“防火墻”(法治論壇) 時(shí)訊2023-03-12

- 春暖花開旅游正當(dāng)時(shí)?騙子已經(jīng)蠢蠢欲動(dòng)2023-03-12

- 風(fēng)清氣正 凝心聚力——2023年全國(guó)兩會(huì)會(huì)風(fēng)2023-03-12

- 【新要聞】電動(dòng)化轉(zhuǎn)型的關(guān)鍵一年 專訪奧迪2023-03-12

- 40 年的硅谷銀行,敗給百年美聯(lián)儲(chǔ)2023-03-12

- 補(bǔ)貼 9 萬后 12 萬買 C6 博主揭雪鐵2023-03-12

- 如何利用好僑鄉(xiāng)資源?全國(guó)人大代表馬學(xué)沛:2023-03-12

- 在中國(guó)推動(dòng)與見證下沙伊恢復(fù)外交關(guān)系,中國(guó)2023-03-12

- 重慶惠民癲康醫(yī)院:女孩夜里尖叫、抽搐,竟2023-03-12

- 環(huán)球關(guān)注:廣東早稻育秧已過半 多地采用大2023-03-12

- 穿越湘江的最大盾構(gòu)隧道貫通2023-03-12

- 多種珍稀保護(hù)動(dòng)物現(xiàn)身廣西木論國(guó)家級(jí)自然保2023-03-12

- 全國(guó)政協(xié)委員丁梅建議:提升基層社會(huì)治理 2023-03-12

- 167 套房源,三個(gè)公租房項(xiàng)目今日向東城區(qū)2023-03-12

- 消息!1TB 存儲(chǔ)影像機(jī)皇!小米 13 Ultra2023-03-12

- 焦點(diǎn)信息:南方科技大學(xué):全國(guó)計(jì)劃招本科生2023-03-12

- 硅谷銀行破產(chǎn)沖擊開始蔓延,英國(guó)180家企業(yè)2023-03-12

精彩推薦

閱讀排行

- “害怕傷到小朋友”,山東7名小學(xué)生路遇火災(zāi)反應(yīng)亮了

- 全球播報(bào):“不宜過早教育分流” 代表建議推行十年義務(wù)教育│兩會(huì)新企望⑤

- Hear the ceaseless sound of China

- “不要有恐懼心理” 社區(qū)醫(yī)師提醒良好心態(tài)應(yīng)對(duì)甲流|熱資訊

- 快報(bào):甲流下的健康保衛(wèi)戰(zhàn)丨深稿

- 新娘“狂飆”200公里接迎親團(tuán)隊(duì) 當(dāng)前視訊

- 河南2023消費(fèi)提振促消費(fèi)活動(dòng)超1500場(chǎng)

- 南陽民警無人機(jī)演練偶遇男子跳河輕生,3分鐘將其救下

- 手工打造“國(guó)潮”!專訪用蘋果樹枝做熊貓丫丫木雕的民間手藝人|面孔 今日熱訊

- 每日動(dòng)態(tài)!信陽無臂小伙街頭賣“口書”:自力更生,努力活著